Работая над оптимизацией сайта под поисковые системы важно отслеживать как много страниц обходится поисковыми ботами, какие именно страницы, как часто обходятся, и т.д.

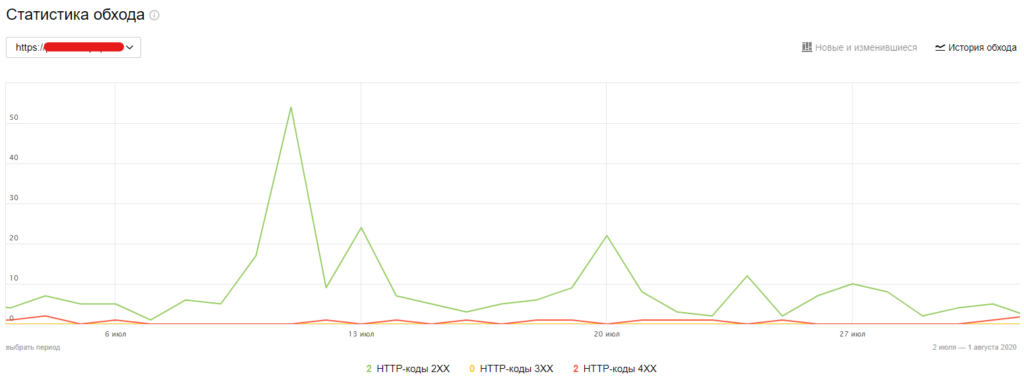

В случае с оптимизацией под Яндекс, есть Яндекс Вебмастер, где информацию по обходу страниц можно найти в отчете «Статистика обхода».

Кроме графиков, в отчете есть таблицы — две вкладки «последние изменения» и «все страницы». Но этих данных не всегда достаточно.

А вот Google такой информации не даёт, и всё что можно найти, это графики по количеству страниц в день, среднему времени ответа сервера и количеству байт загруженных в день. Какие именно страницы Google обошел, какой ответ получил вы не узнаете. Поэтому, если вы занимаетесь технической оптимизацией под Google, ничего кроме анализа логов вам тут не поможет. Собственно, это и есть одна из важных причин использовать анализ логов в своей работе.

Вот список возможностей, которые открывает анализ логов:

- Поиск страниц, о которых вы можете не знать, но они известны боту;

Бывают случаи, когда вы можете даже не подозревать, о том, что бот обходит какие-то неизвестные вам страницы сайта (например, внутренний поиск по сайту или какие-то параметрические URL, да еще и сгенерированные злоумышленниками). Такие страницы могут не попадать в индекс, но при этом сканироваться ботами, их легко обнаружить в логах вашего сайта.

- Поиск страниц, о которых вы знаете, а бот – нет;

Если на вашем сайте есть проблемы с внутренней перелинковкой, бот может не обходить некоторые страницы сайта. Например, ссылки на важные страницы могут находиться на большой глубине клика, или спрятаны в динамическом контенте, недоступном боту. В таком случае с большой вероятностью вы столкнетесь с такой проблемой. Сравнив данные парсинга сайта или карты сайта с данными логов, легко найти страницы, которые по тем или иным причинам не посещали поисковые боты.

- Оптимизация краулингового бюджета;

В своих логах вы с большой вероятностью увидите определенное количество различных параметрических страниц, страниц поиска по сайту, страниц, закрытых от индексации и другого «технического мусора», который не нуждается в сканировании ботами поисковых систем.

- Поиск некачественных страниц (страницы низкого качества значительно реже обходятся ботами ПС);

- Поиск важных страниц (тех страниц, которые чаще всего обходятся ботами ПС или страниц, которые вы считаете важными, тут могут быть сюрпризы);

Сгруппировав данные логов по URL и отсортировав данные по количеству их посещений ботами ПС можно проанализировать страницы, которые обходятся чаще и реже всего.

- Найти дату последнего обхода при необходимости;

Чем анализировать логи?

У меня нет цели собрать все доступные способы, потому не удивляйтесь, если не увидите в списке известный вам сервис или софт. Можете добавить его в комментариях.

Да, если вы планируете анализировать логи, стоит убедиться, что они у вас есть. Проверьте настройки или уточните у администратора сервера, что логи хранятся и хранятся за достаточный период (более месяца), иначе вам нечего будет анализировать.

Да, если вы планируете анализировать логи, стоит убедиться, что они у вас есть. Проверьте настройки или уточните у администратора сервера, что логи хранятся и хранятся за достаточный период (более месяца), иначе вам нечего будет анализировать.

- Самое простое, доступное каждому, это Microsoft Excel, при условии, что у вас не большой сайт (иначе, лог-файл будет слишком большим для загрузки в Excel). Просто загрузив лог-файл в Excel, используя фильтры, сводные таблицы и графики, можно получить массу полезной информации.

- Log file Analyser от Screaming Frog - https://www.screamingfrog.co.uk/log-file-analyser/. Софт платный, но если совесть позволяет, в интернете можно найти кейген.

Данный софт отлично подходит для анализа логов, к тому же позволяет объединять данные логов с данными парсинга Screaming Frog SEO spider-а, что очень круто. Кроме того, при загрузке логов можно выбрать данные каких именно ботов вы хотите вытащить из лога и отфильтровать нужные вам URL. - Jetoctopus - https://jetoctopus.com/log-analyzer/. Платный SaaS проект. Анализ логов + парсер сайта. Кроме того, умеют подтягивать данные из Google Search Console. Маст-хэв для крупных сайтов.

- Power BI - https://siteclinic.ru/blog/web-analytics/analiz-logov/

- Python/R – языки программирования для работы с данными. Если ваши знания позволяют, почему бы и нет.

Решение более серьезных задач

Объединив данные логов с данными парсера (доступность для индексации, глубина клика, ответ сервера), с данными из панелей поисковых систем (наличие в индексе, количество показов, кликов на URL), частотность запросов на URL (суммарная частотность кластера запросов на URL) можно решать более сложные задачи и иметь больший контроль над ситуацией:

- собрать список страниц, которые по данным Search Console не имеют показов и кликов, при этом доступны к индексации и находятся в индексе, но последний раз обходились до обновления контента на них и соответственно требуют переиндексации;

- найти страницы, по которым бот ходит очень часто, при этом они сделаны под НЧ трафик, контент на них редко меняется и большой необходимости в их частом обновлении нет, при этом более важным URL достаётся мало переходов – явно проблемы в структуре сайта и перелинковке;

- Поиск страниц, на которые нет трафика, но идет большой расход ресурсов ПС;

- Поиск неиндексируемых или неканонических URL на которые тратятся ресурсы ПС;

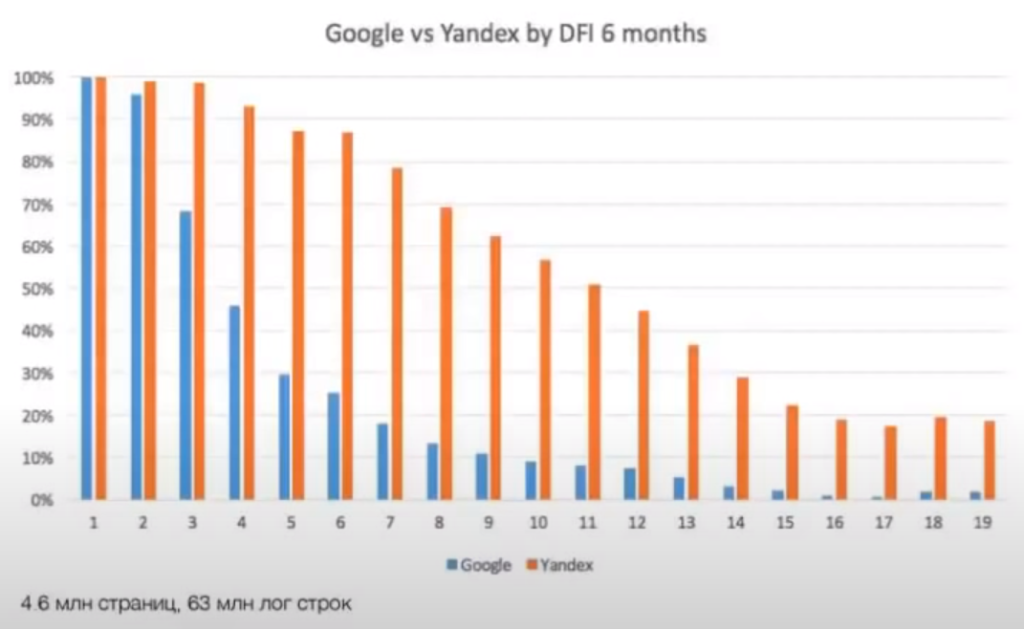

- понять различия в обходе сайта ПС Яндекс и Google. Например, Jetoctopus приводили статистику по глубине сканирования Яндекс-бота и Google-бота за последние 6 месяцев:

Тут речь о группе сайтов в РУ сегменте. И видно, что Яндекс сканирует сайты глубже, намного глубже. Как вывод, при оптимизации под Google – обязательно следите за глубиной клика, иначе Google может не добраться до страницы.

Больше информации об этом исследовании в видео - https://youtu.be/MJQSVoqJhsk

- Анализ необходимости в работе с глубиной клика;

Проанализировав логи и данные какого-нибудь парсера (например, SEO Screaming Frog) вы сможете увидеть страницы, которые не посещаются или редко посещаются ботами поисковых систем. Результатом анализа зачастую становится работа с глубиной клика до таких страниц, особенно на больших сайтах.

- Анализ изменений в сканировании после внесения правок на сайт;

С анализом логов, внеся какие-то изменения на сайт, можно не вслепую надеяться, что изменения приведут к какому-то результату, а отслеживать изменения в краулинге сайта.

- Контроль переезда для крупных сайтов;

При переезде крупного сайта на другой домен, анализ логов — незаменимая вещь. Без контроля обхода сайта поисковыми ботами переезд может сильно затянуться и вызвать массу проблем. С мониторингом краулинга сайта, контролируя ответы сервера для ботов и пользователей вы можете значительно ускорить переезд сайта и потерять в разы меньше поискового и другого трафика.

- Проведение экспериментов и контроль за ними;

Пример простого анализа логов, доступный каждому, при проведении экспериментов с технической оптимизацией.

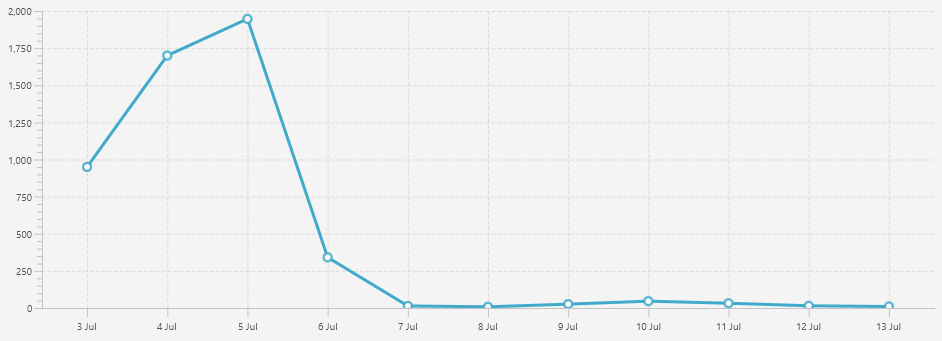

В статье о методах оптимизации пагинации я упоминал метод добавления в файл robots.txt директивы Clean-param для параметров пагинации.

Взяв логи за некоторый период до и после изменений, можно наглядно увидеть поведение Яндекс бота.

График построен с помощью Log File Analyser от Screaming Frog. Аналогичный можно построить в Excel.

Если интересны выводы по данному методу - смотреть здесь - https://seo-insight.ru/articles/pagination-optimization/#8

Если вы еще не занимались анализом логов вашего сайта, надеюсь, я вызвал у вас к этому интерес, и вы извлечете пользу от данного материала.